Das lineare Regressionsmodell, in seiner allgemeinen Form mit \(P\) Kovariaten, basiert auf folgenden Modellannahmen:

\[ Y_{i} = \beta_0 + \beta_1 \cdot x_{1i} + \beta_2 \cdot x_{2i} + \ldots + \beta_P \cdot x_{Pi} + \epsilon_i \qquad (i=1,\ldots ,n) \]

- \(\epsilon_{1}, \ldots, \epsilon_{n}\) sind normalverteilt (Die Normalverteilungsannahme wird benötigt, um Standard-Tests im Regressionsmodell durchführen zu können, für die Schätzung an sich ist sie nicht erforderlich),

$$E(\epsilon_{i}) = 0 $$

$$V(\epsilon_{i}) = \sigma^{2}$$

- \(\epsilon_{1}, \ldots, \epsilon_{n}\) sind unabhängig,

- \( \epsilon_{i}\) und \(X_{i,p} \:(p=1, \ldots, P) \) sind unkorreliert

Etwas weniger technisch lassen sich diese Annahmen wie folgt zusammenfassen:

| Annahme | Was bedeutet das wirklich? | Wann wird die Annahme wahrscheinlich verletzt? | Warum is das ein Problem? |

|---|---|---|---|

| Linearität | Lineare Abhängigkeit zwischen den erklärenden Variablen und der Zielvariable | Das Modell wäre missspezifiziert | |

| Erwartungswert der Störgröße gleich Null | Die Beobachtungen der abhängigen Variable y weichen nicht systematisch von der Regressionsgeraden ab, sondern streuen zufällig darum. | Gut definierte Untergruppen in den Daten können dieses Problem verursachen (Männer vs Frauen). | Verzerrung der Schätzung von \(\beta_{0}\) |

Unabhängigkeit | Es kann nicht der Fall sein, dass das Wissen des Wertes von y für eine Beobachtungeinheit, etwas über den Wert einer anderen Beobachtungseinheit aussagt. | Abhängigkeit der Beobachtungen tritt häufig in der Zeitreihenanalyse auf (Temperaturen in Sommer vs. Winter) | Maßnahmen der Stärke der Beziehung zwischen x und y können sehr irreführend sein |

| Es sollte nicht der Fall sein, dass die Beziehung x/y für eine Beobachtung stärker und für eine andere schwächer ist. | Gut definierte Untergruppen in den Daten können dieses Problem verursachen (Männer vs Frauen). | Bo und B1 werden nicht genau geschätzt. Noch wichtiger ist, dass die Bewertung der Vorhersagegenauigkeit nicht korrekt ist. | |

Residuen normalverteilt | Die Fehlerterme folgen eine Normalverteilung | Das kann immer passieren | Konfidenzintervalle und Hypothesentests sind ungültig. |

| Die unabhängigen Variablen dürfen untereinander nicht zu stark korrelieren. | Es liegt vor, wenn zwei oder mehr erklärende Variablen eine starke Korrelation miteinander haben (Arbeiten und Gehald Bekomen ) | Overfitting in Regressionsanalysemodellen kann vorkommen, Redundanz bei der Interpretation der erklärenden Variablen. |

Die Gültigkeit der Annahmen sollte geprüft werden.

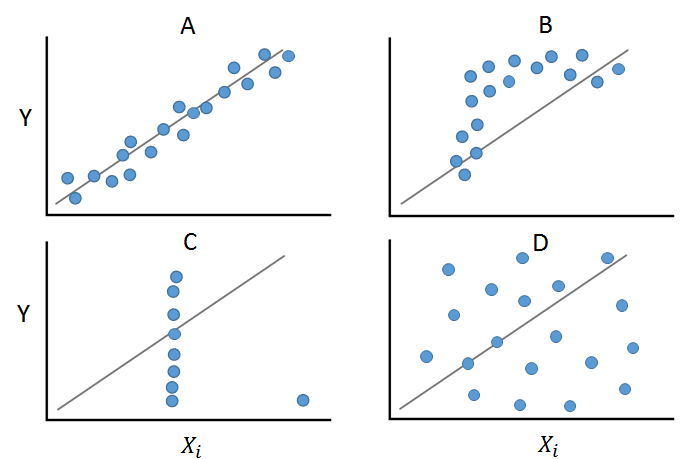

Zunächst sollte untersucht werden, ob zwischen den metrischen unabhängigen Variablen und der abhängigen Variable überhaupt ein linearer Zusammenhang besteht. Dies lässt sich graphisch anhand von Streudiagrammen überprüfen.

Wenn die Beziehung zwischen zwei Variablen nichtlinear ist oder wenn Ausreißer vorhanden sind, schätzt der Korrelationskoeffizient die Stärke der Beziehung falsch. Das Plotten der Daten vor dem Berechnen eines Korrelationskoeffizienten ermöglicht, die lineare Beziehung zu überprüfen und mögliche Ausreißer zu identifizieren. Der Fall (A) zeigt starke positive Korrelation (= steigende Gerade). Fall (B) zeigt einen unpassenden, da nichtlinearen Zusammenhang. Fall (C) veranschaulicht einen Fall, in dem es eine sehr starke lineare Beziehung gibt, mit der Ausnahme einer Beobachtung. Diese hat jedoch einen großen Einfluss auf den Steigungsparameter der Geraden. (D) zeigt ein Beispiel in dem keine Korrelation zwischen den Variablen zu beobachten ist.

Eine andere Möglichkeit ist die sogenannte Partial Residual Plot zu benutzen. Hierbei wird das Verhältnis zwischen einer unabhängigen und der abhängigen Variable unter der Voraussetzung abgebildet, dass auch andere Kovariate im Modell enthalten sind. Ein linearer Zusammenhang wird auf dem Schaubild in Form einer roten Geraden dargestellt. Die grüne Gerade repräsentiert die Modellierung des Zusammenhangs durch sogenannte Splines. Sollte der Zusammenhang nicht linear sein, so können eventuell die im weiteren vorgestellten Transformationen dazu benutzt werden, den Zusammenhang zu linearisieren.

Weiterhin wird vorausgesetzt, dass die Residuen unabhängig sind und eine konstante Varianz aufweisen (\( V(\epsilon_{i}) = \sigma^{2}\)," Homoskedastizität"). Dies kann überprüft werden, indem die geschätzten Werte der abhängigen Variablen in einem Streudiagramm gegen die Residuen gezeichnet werden (sog. Residuenplot).

Dabei handelt es sich ebenfalls um ein Streudiagramm, in dem auf der Abszisse die geschätzten Werte der abhängigen Variablen und auf der Ordinate die geschätzten Residuen abgetragen werden. Die Punkte in dem Diagramm sollten unsystematisch streuen. Das Auftreten einer Trichterform deutet auf eine Verletzung der Annahme konstanter Varianzen („Heteroskedastizität“) hin. Ist eine Systematik in den Punkten erkennbar, so ist diese meist auf eine Verletzung der Unabhängigkeitsannahme zurückzuführen. In Dem Fall (A) verteilen sich die Residuen ungefähr in einem gleichbleibend dickem horzontalen Band. Hier sind weder Abhängigkeiten, noch Heteroskedastizität erkennbar. Formen die Punkte einen „Trichter“ oder eine „Raute“, ist dies ein Hinweis auf eine Verletzung der Annahme gleicher Varianzen (Fall B, C, F). Fälle wie (D) und (E) zeigen einen quadratischen/ logarithmischen Zusammenhang.

Beobachtungen mit großem Einfluss auf die Parameterschätzer lassen sich auch in dieser Art von Streudiagramm erkennen.

Damit man den F-Test und die t-Tests für die Parameter sinnvoll interpretieren kann, müssen die Residuen zudem normalverteilt sein. Um dies graphisch zu prüfen, können zusätzlich die Histogramm und die Normalverteilungsdiagramm untersucht werden. Der erster Output wird dann um ein Histogramm der standardisierten Residuen, dem die Dichte der Standardnormalverteilung überlagert ist, ergänzt (optional). Die Form des Histogramms sollte möglichst der der Kurve entsprechen. Das Histogramm zeigt, dass die Verteilung der Residuen im Vergleich zu Normalverteilung eher rechtsschief ist.

Eine weitere Möglichkeit der Kontrolle der Normalverteilungsannahme der geschätzten Residuen lässt sich unter anderem mit Hilfe eines Quantil-Quantil (Q-Q) Plot überprüfen. Diese Diagramme überprüfen, ob die Residuen der Normalverteilungsannahme genügen. Der Q-Q Plot zeigt starke Abweichungen zwischen den Verteilungen hin. Die Punkte in kleinen und hohen Quantilen liegen über der Ausgleichslinie. Ein solcher Q-Q Plot spricht für eine linksschiefe Verteilung (positive Schiefe). Neben der graphischen Überprüfung der Normalverteilungsannahme können auch Tests auf Normalverteilung wie der Shapiro-Wilk-Test oder der Kolmogorow-Smirnov-Test durchgeführt werden. Falls die Normalverteilungsannahme nicht gegeben sein sollte, gibt es die Möglichkeit Transformationen durchzuführen. Beispielsweise ist das Einkommen häufig nicht normalverteilt, das logarithmierte Einkommen jedoch schon.

Graph (A) kann als normalen "ideal" Q-Q Plot gesehen werden, wobei die Punkten auf der Gerade liegen. Im Fall (B) die Ränder der Verteilung sind leichter als von Normalverteilung. Der Graph (C) zeigt, die typische Verhalten eines Verteilungs mit schwerer Ränder als einer Normalverteilung (S-Graphick). Grahicken (D) und (E) zeigen eine Muster, mit positiven und negativen Bias.

.